סם אלטמן | צילום: בלומברג

סם אלטמן | צילום: בלומברג

מילים מילים, ללא משמעות: שיחות מסוכנות עם הבוט ChatGPT

ChatGPT, הצ'אטבוט הרהוט של OpenAI, הצליח לתפוס את תשומת לב האינטרנט עם הדיאלוג מלא הביטחון שהוא מדמה. אבל התחכום מטשטש את העובדה שאין לבוט שום הבנה על העולם ושאין משמעות לטקסטים שהוא מייצר. כך הוא מפיק בביטחון שטויות גמורות מבלי שנשים לב

1. אם להתרשם מהשנים האחרונות, ייתכן כי רגליהם של משקיעי ההון סיכון עייפות - שהרי ניכר כי הם כל הזמן עומדים בתור. עומדים בתור להשקיע במיזם הקריפטו החדש, בכוכב הבא של נהיגה אוטונומית, בפרויקט החדש המטאוורס, במציאות רבודה, באובר של בעלי החיות, בערים חכמות, בקלינטק, בפינטק, במזון מהונדס או - השלימו כל מה שיכול להיות "הדבר הגדול הבא". התור המשתרך הנוכחי והשיגעון החדש של עמק הסיליקון הוא בינה מלאכותית גנרטיבית. בקרן ההון סיכון הענקית סקויה השוו את המודלים למכשירים הסלולריים החכמים, וגם הם ישחררו עלינו פרץ של יישומים חדשים: "המרוץ יצא לדרך", הכריזו בלי להתבייש.

את העניין הגדול ביותר מושכת חברת OpenAI שהשיקה רק בשבוע שעבר מחולל טקסט בשם ChatGPT, שכבר רשם מעל מיליון משתמשים. ההשתאות סביבו נראית כמעט מוחלטת, צילומי מסך של שיחות עם הצ'אט הציפו את הרשתות החברתיות וכמה בכירי עמק הסיליקון התבטאו בהתלהבות. פול גרהם, מייסד־שותף של המאיץ המפורסם ביותר Y Combinator, צייץ כי "ברור שמשהו גדול קורה"; אלון מאסק צייץ שהוא "טוב ומפחיד. אנחנו לא רחוקים מבינה מלאכותית חזקה בצורה מסוכנת"; ומייסד חברת הענן Box ארון לוי אמר כי " ChatGPT הוא אחד מאותם רגעים נדירים בטכנולוגיה שבהם אתה רואה זיק של איך הכל הולך להיות שונה בהמשך".

מה זה בינה מלאכותית גנרטיבית, מה הצ'אטבוט הזה יכול לעשות שאחרים לא ומה הוא לא יכול, איזו ציפייה הוא מעורר ואיזה כוח לא זוכה לכל התייחסות? מורה נבוכים לצ'אט ששבר את האינטרנט, ואז כתב אותו מחדש. זה נראה סביר, בערך, ויש גם כאלו שמאמינים שהוא ישנה את העתיד. בטוח, אולי.

2. בינה מלאכותית גנרטיבית (Generative AI) מתייחסת לאלגוריתמים שמסוגלים לייצר תוכן חדש — טקסטואלי, חזותי או שמיעתי – עם התערבות אנושית מעטה יחסית. יישומים של אלו אינם חדשים לחלוטין, אך השנה האחרונה היתה משמעותית לתחום, משום שהיתה הראשונה שבה יישומים באיכות גבוהה הופצו לציבור הרחב להתנסות ללא עלות (או בעלות נמוכה במיוחד). בין היתר הפכו מפורסמים מחולל התמונות DALL-E 2 (גם הוא מבית היוצר של OpenAI), מחולל התמונה Imagen והשפה LaMDA של גוגל, Stable Diffusion ו־Midjourney.

הצ'אטבוט של OpenAI נועד לקיים אינטראקציה בצורת שיחה. "פורמט הדיאלוג מאפשר ל־ChatGPT לענות על שאלות המשך, להודות בטעויות, לערער על הנחות יסוד שגויות ולדחות בקשות בלתי הולמות", נכתב באתר של OpenAI, ארגון למטרות רווח. אף שבוטים הם אינם תופעה חדשה, ChatGPT בולט משום שהתשובות שהוא מעניק מותירות רושם חזק שהן רלבנטיות, טובות, מנומקות ומנוסחות היטב. המודל אף "זוכר" את השתלשלות השיחה עצמה כך שנוצרת התחושה של שיחה יותר טבעית (אגב, רק באנגלית). "אין לי צורה פיזית, ואני מתקיים רק כתוכנת מחשב", השיב הבוט כששאלתי אותו על מהותו והוסיף, "אני אינני אדם ואין לי היכולת לחשוב או לפעול על דעת עצמי". מנגנון השאילתה המלוטש הזה הביא משתמשים אחדים להכריז ש"גוגל מתה" והצ'אט מסמל שינוי טקטוני שמתקרב לשוק העבודה. אחרים הציעו כי הבוט, או לפחות אם נרתום את המיומנות שלו, יוכל לשנות מן היסוד שורה של מקצועות. בין היתר עריכת דין, שירות לקוחות, תכנות, מחקר בכלל ואקדמיה בפרט, שירותים פיננסיים, כל מה שנוגע לכתיבת תוכן לרבות שיווק, ספרות או עיתונות ואף מקצועות ההוראה.

כדי לחקור את האפשרויות היישומית של מודלים אלו צריך להתחיל מהבסיס — כיצד הצ'אטבוט ודומיו עובדים? כפי שנרמז בשמו, הצ'אט פועל באמצעות מודל שפה טבעית (NLP) ממשפחת 3־GPT. המודל, בקצרה, הוא כלי סטטיסטי לניבוי מילים ברצף. כלומר, אחרי אימון על מערכי נתונים גדולים, המודלים מנחשים באופן מתוחכם איזו מילה צפויה להגיע אחרי איזו מילה (ומשפט אחרי משפט). 3־GPT הוא מודל שפה גדול, ויש לו פי 10 יותר פרמטרים (הערכים שהרשת מנסה לייעל באימון) מכל דגם קודם לו. 3־GPT אומן על נתונים בגודל 45 טרה־בייט, ממקורות מגוונים כמו ויקיפדיה, שני קורפוסים של ספרים וסריקות דפי אינטרנט גולמיים. המודל אף עובר תהליך המכונה "כוונון עדין", שבו מאמנים אותו על קבוצת הנחיות והתגובות הצפויות להנחיות. באתר החברה מסבירים מעט על אופן אימון הצ'אטבוט, זה כולל הזנת תשובות אנושיות בכתב ל־GPT כנתוני אימון, ולאחריו שימוש בשיטת "לימוד חיזוק" (פרס־עונש) כדי להביא את המודל לספק תשובות משתפרות. זה פחות או יותר מה שאנחנו יודעים על המודל, וכשחשבתי שאולי אשיג יותר מידע אם אפנה בשאילתה בנושא ל־ChatGPT, זכיתי בתשובה כללית (שוב ושוב) כי אינו יכול לענות משום שמידע זה הוא "קניין OpenAI".

גם בלי לדעת את כל הפרטים, ברור שמאגרי הנתונים שעליו אומן המודל מכילים מידע רב מזה שאדם אחד יוכל אי פעם להיחשף אליו בימי חייו. למידה אינטנסיבית זו מאפשרת למודל, בהינתן טקסט קלט מסוים, לקבוע באופן הסתברותי מה מאוצר המילים הידוע לו יגיע אחר כך. זו אינה רק המילה מספר 50 הסבירה סטטיסטית ביותר, אלא גם המילה הסבירה מבחינת פרמטרים נוספים, כמו סגנון כתיבה או טון.

הדגש באופן פעילות מודלים מסוג זה כולל מילים כמו "סטטיסטיקה" ו"הסתברות", לא "שפה" או "משמעות". כי אף שהמודל יודע לבנות צירופים משכנעים, התוצאה שהוא מפיק לא קשורה ולא מתקשרת באופן מכוון לשום רעיון לגבי העולם ואין למשמעות המילולית של מה שהוא מפיק כוונה - הצ'אטבוט לא מנסה לתקשר דבר. הצירופים שהמודל מרכיב באופן מחושב (לעילא) הופכים בעלי משמעות רק כשמישהו יכול לייחס להם משמעות, כלומר רק כשאדם מהעבר השני קורא אותם. זאת, בשונה לחלוטין מאדם שאומר את שאומר, או כותב את שכותב, במטרה להעביר רעיון מכוון. זוהי נקודת מפתח כדי להבין את האפשרויות הגלומות ב־ChatGPT וכלים אחרים. מודלים אלו יכולים לחקות שפה טבעית בריאליסטיות ולהיות מדויקים להפליא בניבוי המילים או הביטויים שסביר להניח יגיעו בהמשך במשפט או בשיחה. אבל זה כל מה שהם עושים - הם לא מבינים מה הם אומרים, ולמרות השם המטעה שהעניקו להם כ"בינה מלאכותית", הם חסרי שכל או בינה.

החוקרות אמילי בנדר, טימט גאברו ואחרות מציעות לתאר את התהליך והמודלים כ"תוכי סטוכסטי". תוכי, כי הוא רק חוזר על מה שהזינו אותו ללא כל הבנת המשמעות, וסטוכסטי, כי התהליך עצמו אקראי. "הטקסט שנוצר אינו מבוסס על כוונה תקשורתית, מודל של העולם או מודל של מצב נפשי של הקורא", הן כותבות במאמר מ־2021 ומסבירות שמה שאנו חוזים בו הוא למעשה מערכת לחיבור אקראי של רצפי צורות לשוניות, "על פי מידע הסתברותי על האופן שבו הם משתלבים, אך ללא כל התייחסות למשמעות: תוכי סטוכסטי".

3. קוהרנטיות המודלים מייצרת תחושה כאילו המכונה "מבינה" מה שואל האדם מן העבר השני, ואנחנו מבינים את תשובותיה בהקשר זה. זהו מהלך אינטואיטיבי והגיוני: שפה מייחדת את המין האנושי מכל היתר וכשנראה מכונה שקרובה להשיג או אפילו ממש השיגה יכולת זו, אנו נוטים לדמיין, להקביל ולהשליך את האינטליגנציה האנושית כפי שאנו מבינים אותה על המכונות. המשגה הזה אולי מתרחש אינטואיטיבית, אך אנו גם נדחפים על ידי מפתחי המודלים לחשוב שאלגוריתם ש"מתמרן צורה לשונית", גם "רכש מערכת לשונית". כך למשל כמה ימים אחרי השקת ChatGPT, צייץ מנכ"ל OpenAI סם אלטמן: "אני תוכי סטוכסטי, וגם אתם". עשה כמותו אך יותר באלגנטיות מנכ"ל גוגל סונדאר פיצ'אי, שעם השקת הצ'אט שלהם LaMDA, הסביר כי "נניח שרצית ללמוד על אחד מכוכבי הלכת האהובים עליי, פלוטו. LaMDA כבר מבינה די הרבה על פלוטו ומיליוני נושאים אחרים". אנחנו לא תוכים, והבוטים לא "מבינים". הקבלות שגויות אלו הן מה שצמד החוקרים בריאה וקרוס תמצתו במחקרם כמטאפורה ש"מייחסת למוח האנושי פחות מורכבות משמגיע לו ומייחס למחשב יותר חוכמה ממה שצריך".

זוהי אינה עמדתם של "ספקנים" או "מרירים" לקבוע כי המודלים אינם שולטים בשפה אנושית או כי הם אינם אינטליגנטים, ChatGPT באמת לא מבין משמעות, הקשר, מה הוא נשאל או מה הוא עונה. זאת הסיבה מדוע התפוקות של כל מחוללים אלו משמשות בעיקר כ"כלים שמסייעים לתהליך יצירתי אנושי" (להבדיל מכלי שמחליף תהליך יצירתי אנושי). אך מה בעתיד? האם ניתן לצפות שהכלים ישתפרו כל כך שיעלו על היצירתיות האנושית, יהיו מספיק טובים כדי להשתמש בהם כמוצר סופי? האם יהיה ניתן להשתמש בהם כמנוע חיפוש, כלי עיתונאי או כלי המלצות לטיולים? קשה לקבוע, מה שניתן לעשות הוא לשים מגבלות על עומק הפריסה של הטכנולוגיה, בהשוואה להייפ העצום שלו היא זוכה.

נתחיל מהרעיון שאפשר להשתמש בצ'אט ככלי שיחליף כתיבת מאמרים, ידיעות חדשותיות או כל תוכן שנועד לשקף עובדות או רעיונות מנומקים כמו מסמכים משפטיים, הסכמי רישוי או חוזים או לסייע לתלמיד להכין את שיעורי הבית שלו. ChatGPT ודומים לו לא יכולים להתעסק בכתיבה עובדתית, או לכל הפחות עדיף שלא יתעסקו. זאת משום שאף שהבוט נחשף לכמות עצומה של נתונים, אין לו גישה לעובדות באופן שבו אנו עוסקים בעובדות, פשוט כי הבוט לא "מבין" מהן עובדות, לא יכול לבצע שיפוט לגבי תקפותן של טענות — ולא יכול לצטט או להפנות למקורות (איכותיים או לא) שעליהם הוא נסמך. הדרך היחידה לעמוד על כך שקביעותיו נכונות, היא רק במקרה מי ששואל בקיא בעובדות.

כל זה מתרחש בעידן שבו בוטים נפרסים כל העת על ידי גורמים זדוניים כדי להתל בנו במרחב — אם זה חדשות מזויפות או ביקורות על מוצרים. בעיה כה ידועה, שמרביתנו כבר משקיעים מאמץ מיוחד כדי לפענח מה אמת ומה לא - ומחפשים את ה"כותב" או "הממליץ" האנושי והאותנטי. ב־OpenAI יודעים כמה זה מסוכן להישען על הבוט שלהם בחיפוש עובדתי, ומעלים זאת כנקודה ראשונה "במגבלות" המודל: "ChatGPT כותב לפעמים תשובות שנשמעות סבירות, אך למעשה הן לא נכונות או שטויות. תיקון בעיה זו הוא מאתגר, שכן... אימון מפוקח מטעה את המודל מכיוון שהתשובה האידיאלית תלויה במה שהמודל יודע, ולא במה שהצד האנושי יודע".

מה לגבי חיפוש? לקבל תשובות מהירות על שאלות פשוטות הוא דרך נוחה להתנהל בעולם. לא אחת נוהגים לשאול עוזרות וירטואליות "מה מזג האוויר?" או "מה השעה בניו יורק?". כל עוד השאלות פשוטות, אין רע בנוחות טכנולוגית. אך לקבל תשובות ישירות לשאלות מורכבות ממשכפל של דפוסי שפה הוא דרך מסוכנת לחיפוש מידע. לא רק שהתשובות עלולות להיות שגויות או לא רלבנטיות, הן גם ממש — בשל נטייתנו לאמץ כלים - מסוגלות לטשטש את מורכבות העולם. לא עוד מאמץ לבחון תשובות מגוונות בין תוצאות החיפוש, להתאמץ באוריינות טכנולוגית לברור את האמת מן השקר, את העובדה מהבדיה, לחקור נושאים שהשאלה עליהם לא ממש ברורה למחפש עצמו, או שהתשובה לא מוסכמת היסטורית. כל מה שנקבל הוא פסקנות אלגוריתמית לא מנומקת.

מה על כתיבת תוכן? בשבוע האחרון היה זה טרנדי לשתף ברשתות החברתית חיבורים שונים של ChatGPT כתחליף ליצירת תוכן יצירתי פחות או יותר. פסקאות על גבי פסקאות שנועדו להציג יצירתיות אלגוריתמית בשירה, כתיבה עיתונאית, מחקר אקדמי או פרוזה. לעתים התוכן ברשתות החברתיות נועד להתל בקוראים, ומסתיים במשפט ארס פואטי — איך הפוסט הזה שמסביר מה זה ChatGPT בעצם נכתב על ידי ChatGPT. קשה לדעת כמה באמת קוראים רנדומליים נפלו בפח וחשבו שהטקסט נוצר על ידי אדם, אולם גם כשהמחולל הצליח היטב במשימתו, הוא עדיין יצר תחושה חסרת עומק, מפיק לעתים טקסט חלול שנראה יותר כמו "קופי פייסט" מאשר יצירה מקורית או שוטפת. זה לא אומר שלא ניתן לשלב שימוש בו היכן שאין צורך בעומק, למשל בדיווחים על תוצאת משחק כדורגל או מזג האוויר.

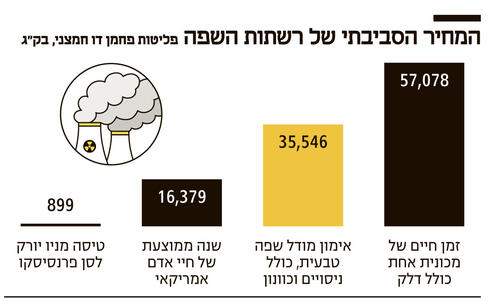

4. בעיות אלו לא יפתרו אם המודל ייחשף למאגרי נתונים גדולים יותר, יצויד במודלים של שפה טבעית עם פרמטרים רבים יותר ויהיה "חזק יותר". לא כל דבר אפשר לפתור בגודל או כוח מחשוב. אבל כוח מחשוב הוא בהחלט עדיין חלק מהשיחה. אימון של 3־GPT עלה 12 מיליון דולר, ומאמר אחד מ־2019 מאוניברסיטת מסצ'וסטס מצא כי אימון מודל אחד מייצר כמות פחמן דו־חמצני שווה ערך לחמש מכוניות בתקופת כל חייהן הממוצעת. משמעות העלויות הכלכליות, האנרגטיות והסביבתיות העצומות היא שכלים אלו הם בפיתוחם הבלבדי של חברות ענק או מיזמים ממומנים היטב. וכשמשקיעים הון מצפים גם לראות הכנסות. הציבור הרחב אינו מקור ההכנסה הישיר ליישומים אלו. הציבור רק היעד בשרשור בידי חברות אחרות שאולי יטמיעו אותם איפה שרק אפשר. זאת הסיבה שהאמינות שאנו מייחסים לצ'אטים הללו כה משמעותית, לכן חשוב במיוחד לשים לב למסגר אמינות זו במקומה, ולקבוע מסגרת רגולטורית ברורה בנוגע לשימוש בכלים אלו. אם לא תיקבע מסגרת אתית לשימוש בכלים אלו, מה שנקבל הוא תפוצתו ההמונית של כלי שמוריד עלויות של הפקת תוכן, ובגללו נדרש להשקיע אנרגיה נוספת ולפתח מיומנויות חדשות במטרה להבדיל בין אמת ושקר. בהצלחה לנו.

* * *

מי עומד מאחורי הבוט

Open AI מחפש בינה מלאכותית "בטוחה"

בשנת 2015 הוקם OpenAI כארגון ללא מטרות רווח, על ידי שורת משקיעים מעמק הסיליקון בהם אלון מאסק, סם אלטמן ופיטר תיל. משימתה הראשונית של החברה היא "לגלות ולממש את הדרך לבינה כללית מלאכותית בטוחה" (כלומר לפתח מחשב בעל תודעה) ואז לחלוק תוצרים אלו עם העולם.

הרעיון היה שעדיף לפתח טכנולוגיה בעלת פוטנציאל הרסני בידיים "הנכונות" (זאת אומרת שלהם והצוות שיבחרו), במקום שזו תפותח בבלעדיות של חברות למטרות רווח, כמו גוגל ופייסבוק.

עם זאת ב־2019 הארגון שינה את הייעוד שלו למטרות רווח כדי למשוך הון והון הם משכו — מיליארד דולר ממיקרוסופט, שגם קיבלה בשל כך גישה למנעד הפטנטים והתוצרים המוגנים בקניין רוחני שפיתחה.

לפי המודל החדש, OpenAI התחייבה לשלם לכל משקיע שלה עד פי 100 מהשקעתו, כל רווח מעל יחזור לציבור.